在大模型的世界里,上下文长度始终是一个限制。当文档太长、图表太复杂,传统语言模型往往“看不完”。而最近,来自 DeepSeek AI 的一个开源项目——DeepSeek-OCR,提出了一种颠覆式的思路:

“与其让语言模型读无穷无尽的文字,不如把文字‘看’成图像,再压缩成视觉信号。”

一、什么是 DeepSeek-OCR?

DeepSeek-OCR,全名 DeepSeek-OCR: Contexts Optical Compression,是 DeepSeek AI 发布的一项研究,核心理念是:

通过光学(视觉)方式压缩长文本上下文,让模型能用更少的 token 理解更多内容。

简单来说,它不只是一个 OCR(光学字符识别)模型,而是一种“视觉化上下文压缩框架”。

它把原本冗长的文档内容转化成少量的 视觉令牌 (vision tokens),再让语言模型(如 DeepSeek 3B-MoE)从这些视觉信息中“还原出”文本与结构。

二、为什么它重要?

传统的文本输入方式会让大模型的 token 消耗飞速膨胀:

一页扫描文档动辄上千 token,尤其当文档包含表格、公式、图表、布局信息时,语言模型根本“装不下”。

DeepSeek-OCR 的贡献在于:

- 把整页文档压缩成 不到原来 1/10 的 token 数;

- 同时保持 97% 以上的识别准确率;

- 即使压缩 20 倍,依然能保持约 60% 的精度;

- 单块 A100 显卡每天可处理 20 万页以上文档。

这意味着:

以前要几百块 GPU 才能训练或处理的大型文档,如今一台显卡也能跑。

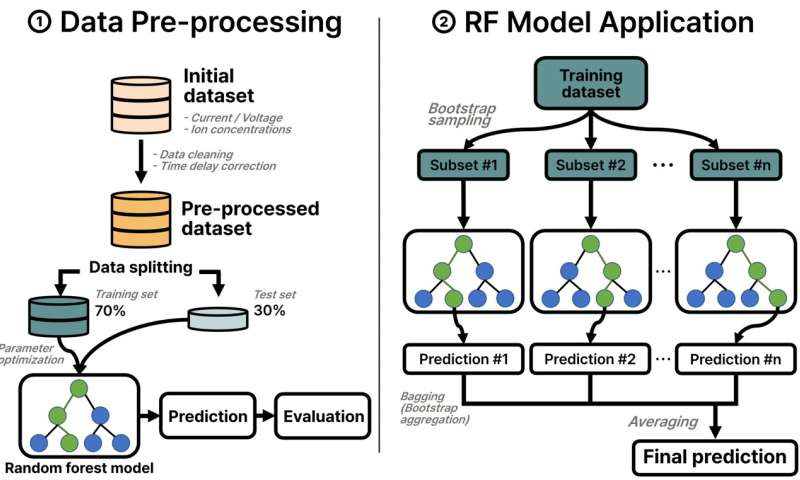

三、架构原理

DeepSeek-OCR 的架构分为两部分:

| 模块 | 作用 | 技术亮点 |

|---|---|---|

| DeepEncoder | 将图像输入编码为视觉令牌(Vision Tokens) | 捕捉文字、布局、表格、图表等空间结构 |

| DeepSeek-3B-MoE-A570M | 混合专家模型,用于从视觉令牌中恢复或理解文本 | 提供语言层面的解码与推理能力 |

整体流程如下:

- 输入一页复杂文档(含图表、表格、公式)。

- DeepEncoder 将其转化为约 100 个视觉令牌。

- 解码器从这些视觉令牌中输出文本或语义理解。

与传统 OCR 相比,DeepSeek-OCR 不仅识别文字,还保留 版式信息(layout)与空间逻辑,让模型“理解”页面结构,而非仅仅“识别”文字。

四、性能与测试

在公开的论文与实验中,DeepSeek-OCR 的表现极具突破性:

| 指标 | 表现 |

|---|---|

| 压缩比 < 10× | 识别精度 ≈ 97% |

| 压缩比 ≈ 20× | 精度 ≈ 60% |

| 单 GPU 处理效率 | 每天 200 000 页以上 |

| 对比模型 | 优于 GOT-OCR 2.0(256 token/页)与 MinerU 2.0(6000 token/页) |

这让它不仅是一个 OCR 模型,更是一种“为大模型节省上下文预算”的全新范式。

五、应用场景

DeepSeek-OCR 的潜在用途非常广泛:

- 📚 科研与教育:批量数字化书籍、学术文献、图表资料。

- 💼 企业档案处理:高效扫描与结构化理解合同、报表、凭证。

- 🔍 大模型前端预处理:作为 LLM 的“视觉压缩入口”,在有限 token 下提供更多上下文。

- 🧩 训练数据生成:为 LLM /VLM 批量生产干净的语料和视觉数据。

六、优缺点分析

| 优点 | 说明 |

|---|---|

| 🔹 高压缩率 | 最高可减少 token 消耗 10–20 倍 |

| 🔹 保留布局信息 | 能理解表格、图表、排版结构 |

| 🔹 开源可复现 | GitHub + Hugging Face 均可直接部署 |

| 🔹 成本更低 | 减少显存和推理时间 |

| 局限 | 说明 |

|---|---|

| ⚠️ 压缩过高时精度下降 | 超过 20× 压缩时识别质量显著降低 |

| ⚠️ 对复杂手写/特殊字体支持未知 | 主打印刷体与标准文档 |

| ⚠️ 仍需较强 GPU 推理能力 | 编码器部分计算密集 |

| ⚠️ 国际监管因素 | DeepSeek AI 在部分地区有使用限制 |

七、部署与使用

项目完全开源,可在 GitHub 与 Hugging Face 上获取。

推荐环境:

Python 3.12.9

PyTorch 2.6.0

Transformers 4.46.3

CUDA 11.8

Flash-Attn 2.7.3示例代码:

from transformers import AutoProcessor, AutoModelForSeq2SeqLM

from PIL import Image

processor = AutoProcessor.from_pretrained("deepseek-ai/DeepSeek-OCR")

model = AutoModelForSeq2SeqLM.from_pretrained("deepseek-ai/DeepSeek-OCR", device_map="auto")

img = Image.open("sample_page.png")

inputs = processor(images=img, return_tensors="pt").to("cuda")

outputs = model.generate(**inputs)

text = processor.decode(outputs[0], skip_special_tokens=True)

print(text)八、未来展望

DeepSeek-OCR 展示了一个重要趋势:

未来的“阅读”,不一定靠文字。

当大模型逐渐从“文本理解”扩展到“文档理解”,视觉化的信息压缩将成为新的计算范式。

它可能不仅应用于 OCR,还将用于:

- 文档记忆压缩

- 多模态上下文融合

- 低带宽远程推理

- AI 教育 / 知识图谱生成

在视觉与语言的交汇处,DeepSeek-OCR 让我们看到:

阅读的极限,不在字数,而在想象力。

📎 参考资料:

- DeepSeek AI GitHub:github.com/deepseek-ai/DeepSeek-OCR

- arXiv 论文:arxiv.org/abs/2510.18234

- Medium 深度解读:Vision-Text Compression and Context Efficiency

- Skywork AI Blog:DeepSeek-OCR: 2025 Context Compression for Document AI

Github:https://github.com/deepseek-ai/DeepSeek-OCR

油管:https://youtu.be/TqrxH2lEJ4Q