Twelve Labs 推出了 Pegasus-1,这是一款具有约800亿参数的先进视频-语言基础模型。

从10秒到长达数小时的视频内容它都能进行处理,并理解识别和解析视频生成更全面、更准确的文本描述。

它可以全面地理解视频中的人物、物体、场景,以及背景音乐、对话等。

主要功能:

1、多模态理解:

Pegasus-1 不仅仅处理视频的视觉信息,还能理解音频和语音信息。这意味着它可以更全面地理解视频内容,包括在视频中出现的人物、物体、场景,以及背景音乐、对话等。

2、高效的长视频处理:

该模型优化了对不同长度的视频,从短达10秒到长达数小时的内容进行管理和处理的能力。

3、视频-文本生成:

通过单一的 API 调用,开发者可以促使 Pegasus-1 模型从他们的视频数据中生成特定的文本输出。这包括但不限于视频摘要、关键点提取、自动生成的标签和标题等。

4、先进的性能指标:

在 MSR-VTT 数据集和 Video Descriptions 数据集上,相对于现有的最先进模型,Pegasus-1 显示了 61% 和 47% 的相对改进。

5、API 访问:

Pegasus-1 提供了一组视频到文本的 API,这些 API 非常灵活,可以用于各种下游任务。

详细介绍:https://app.twelvelabs.io/blog/introducing-pegasus-1

工作原理:

与许多将视频理解框定为图像或语音理解问题的方法不同,Twelve Labs 采用了“视频优先”的策略。

这一策略有四个核心原则:高效的长视频处理、多模态理解、视频本地嵌入和视频与语言嵌入之间的深度对齐。

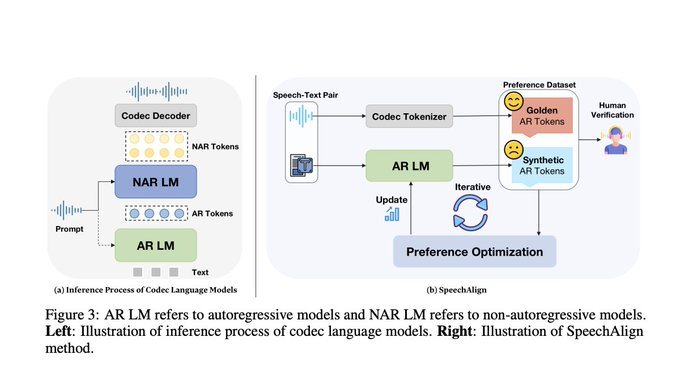

模型由三个主要组件组成:视频编码器、视频-语言对齐模型和语言解码器。

1、视频编码器:负责从视频中提取视觉、音频和语音信息,并生成视频嵌入(Embeddings)。它会评估视频帧及其时间关系,以获取相关的视觉信息,同时处理音频信号和语音信息。

2、视频-语言对齐模型:这一步是桥接视频嵌入与语言模型领域的关键。它确保语言模型能以与理解文本标记相似的方式来解释视频嵌入。

3、语言解码器:利用其广泛的知识库,解码器根据输入的用户提示来解释对齐后的嵌入,并将这些信息解码为连贯、易于阅读的文本。

这三个组件共同训练,使模型能够更准确地理解和生成与视频内容相关的文本。

数据集:

Twelve Labs 收集了超过 3 亿个多样性丰富、精心策划的视频-文本对。这使得它成为用于视频-语言基础模型训练的最大的视频-文本语料库之一。

初始训练子集:技术报告基于一个包含 3500 万视频-文本对和超过 10 亿图像-文本对的初始训练运行。这个子集占总数据集的大约 10%。

这个数据集不仅规模庞大,而且质量高,多样性丰富,这有助于 Pegasus-1 在多个评估指标上实现先进的性能。

MSR-VTT数据集介绍:https://microsoft.com/en-us/research/wp-content/uploads/2016/06/cvpr16.msr-vtt.tmei_-1.pdf

ideo-ChatGPT视频描述数据集:https://arxiv.org/pdf/2306.05424

原文:https://twitter.com/i/status/1718456086150435074