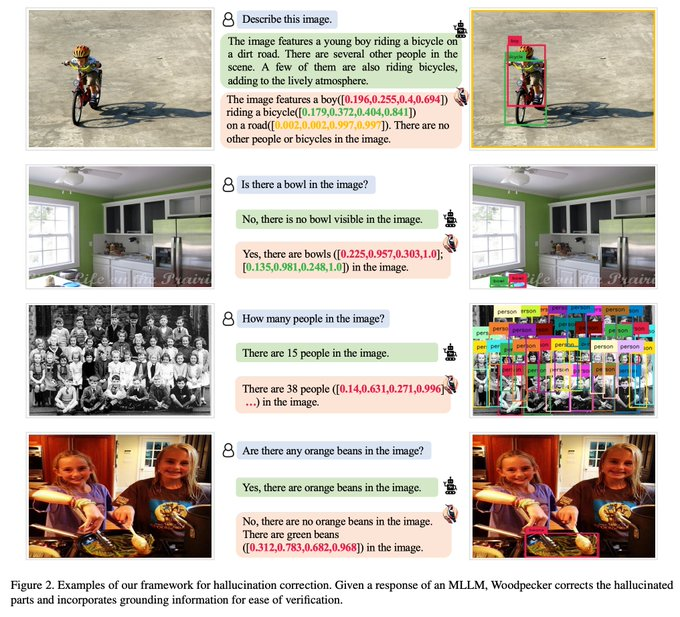

一种纠正多模态大语言模型”幻觉”大方法。

Woodpecker不依赖于重新训练模型或使用特定的数据集,通过一种无需训练的方式来解决这个问题。它是一个后处理步骤,可以应用于任何现有的多模态大型语言模型。

在POPE基准测试中,相对于基线MiniGPT-4和mPLUG-Owl,准确度提高了30.66%/24.33%。

HuggingFace:https://huggingface.co/papers/2310.16045

论文:https://arxiv.org/abs/2310.16045

GitHub:https://github.com/BradyFU/Woodpecker

Demo演示:https://60d1b7c6f5408b81d1.gradio.live

工作原理:

Woodpecker提供了一种全面而有效的方法来解决多模态大型语言模型中的幻觉问题,而无需进行昂贵的重新训练或使用特定的数据集。

Woodpecker是一个五阶段的流程,每个阶段都有其特定的算法和技术。例如,在视觉知识验证阶段,可能使用卷积神经网络(CNN)进行图像分类;在关键概念提取阶段,可能使用TF-IDF或Word2Vec等算法。

1、关键概念提取: 通过自然语言处理技术,如命名实体识别(NER)或关键词提取,从生成的文本中提取关键概念。

2、问题提出: 一旦识别出关键概念,Woodpecker会自动生成问题,这些问题旨在验证这些概念在视觉内容中是否得到了准确的表示。

3、视觉知识验证: 这一步使用图像识别或对象检测算法来回答前面提出的问题。这些算法通常基于深度学习,并已经在大量的图像数据上进行了训练。

4、视觉声明生成: 根据视觉验证的结果,生成一组声明。这些声明用于描述图像内容与文本内容之间的关系。

5、幻觉修正: 最后,这些视觉声明被用来修正生成的文本。如果文本中的某个信息与图像不一致,它将被修改或删除。

核心技术:

Woodpecker 的核心运作涉及三个不同的 AI 模型的集成,这些模型被精心组织起来以解决幻觉问题。这三个模型分别是 GPT-3.5 Turbo、Grounding DINO 和 BLIP-2-FlanT5,它们起到了评估者的关键作用。

1、GPT-3.5 TurboGPT-3.5涡轮

这是一个大型的自回归语言模型,主要用于生成和理解自然语言文本。在 Woodpecker 中,它可能用于关键概念提取和问题构建阶段。

2、Grounding DINO恐龙接地

DINO 是用于自监督视觉表示学习的模型。在 Woodpecker 中,它可能用于视觉知识验证阶段,以确保生成的文本与图像内容一致。

3、BLIP-2-FlanT5

这是一个用于多模态学习的模型,能同时处理文本和图像。在 Woodpecker 中,它可能用于视觉声明生成和幻觉纠正阶段。

这三个模型细致地审查和识别幻觉,为需要纠正的模型提供精确的指导,引导它使其输出与其训练数据保持一致。

通过这种多模型集成的方法,Woodpecker 能够更全面地解决多模态大型语言模型中的幻觉问题,提供更准确和一致的输出。