- Phi-2 仅有 2.7B参数

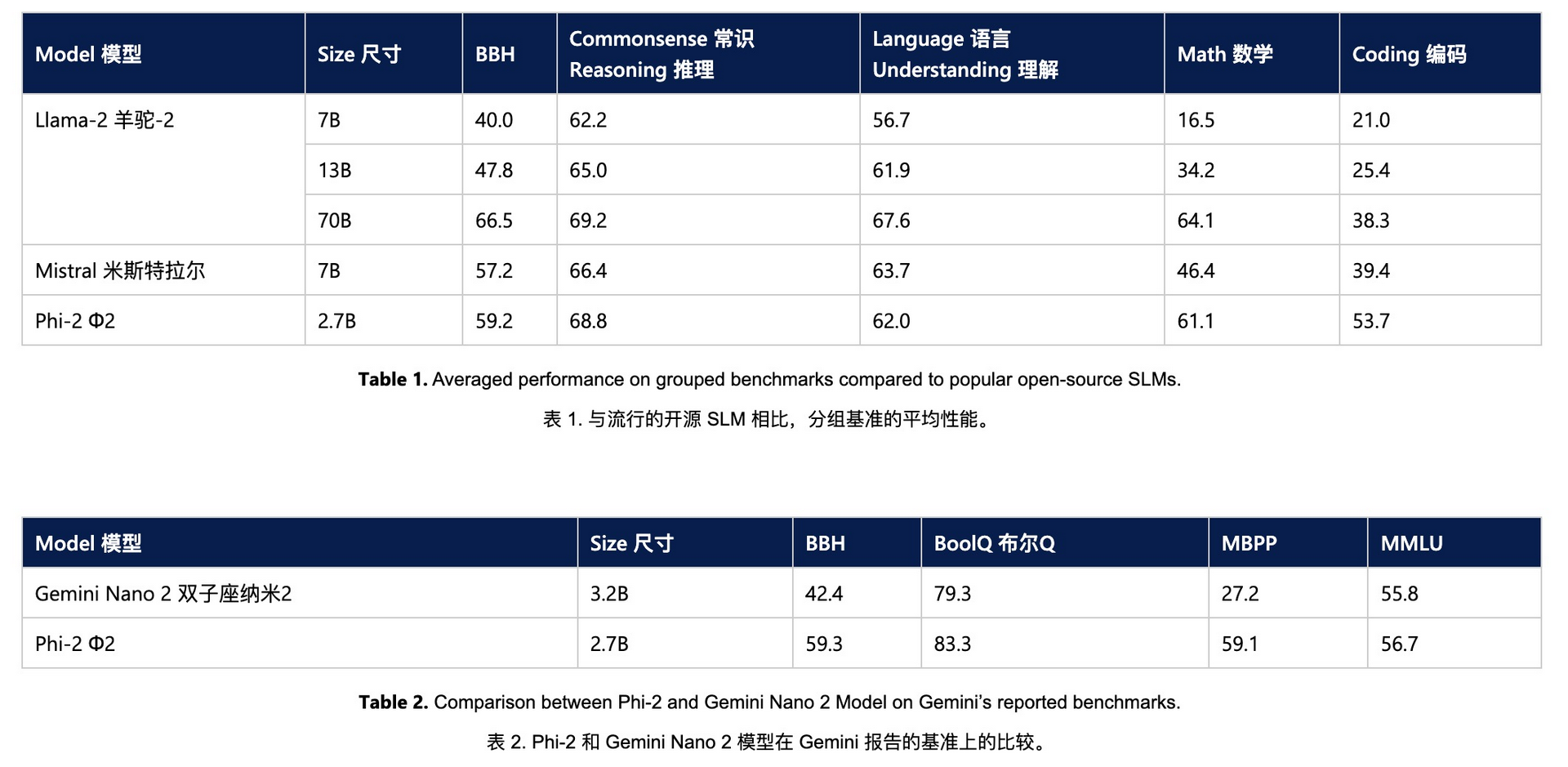

- Phi-2 超越了分别拥有7B和13B参数的Mistral和Llama-2模型

- 甚至在多步推理任务上超越了参数量是其25倍的Llama-2-70B模型

- 微软称Phi-2性能优异得益于其训练数据的质量非常高,他们弄了一个“教科书级”的数据集

“教科书级”的数据集:为了训练 Phi-2,研究团队创建了特定的数据集,这些数据集专门设计用来教授模型进行常识推理和理解一般知识。这些合成数据集可能包含各种情景和问题,旨在提高模型在处理现实世界问题时的准确性和可靠性。

知识迁移:另外研究团队还成功地将已经学习到的知识和模式从较小的Phi-1.5模型转移到了较大的Phi-2模型。这不仅提高了 Phi-2 的学习效率,还加速了其训练过程,使其能够更快地达到高水平的性能。

详细:https://microsoft.com/en-us/research/blog/phi-2-the-surprising-power-of-small-language-models/