VAR首次使GPT风格的AR模型在图像生成上超越了Diffusion transformer。

同时展现出了与大语言模型观察到的类似Scaling laws的规律。

在ImageNet 256×256基准上,VAR将FID从18.65大幅提升到1.80,IS从80.4提升到356.4,推理速度提高了20倍。

详细介绍:

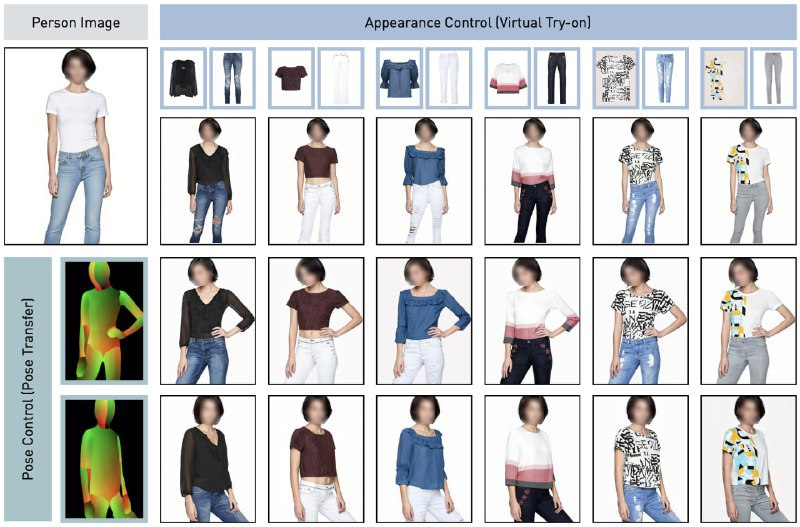

视觉自回归模型(VAR)是一种新的图像生成范式,它将自回归学习重新定义为从粗到细的”下一尺度预测”或”下一分辨率预测”,有别于标准的光栅扫描”下一token预测”。

这种简单直观的方法让自回归transformer能够快速学习视觉分布并具有良好的泛化能力:

VAR首次使GPT风格的AR模型在图像生成上超越了扩散transformer。

在ImageNet 256×256基准上,VAR将FID从18.65大幅提升到1.80,IS从80.4提升到356.4,推理速度提高了20倍。

实证验证了VAR在多个维度包括图像质量、推理速度、数据效率和可扩展性上都优于Diffusion Transformer。

随着VAR模型的扩大,它展现出了与大语言模型观察到的类似幂律缩放规律,线性相关系数接近-0.998,有力证明了这一点。

VAR进一步展示了在下游任务如图像修复、外推和编辑上的零样本泛化能力。

这些结果表明,VAR初步模拟了大语言模型的两个重要特性:缩放规律和零样本泛化。

研究人员已经公开了所有模型和代码,以促进AR/VAR模型在视觉生成和统一学习中的探索。

VAR算法为计算机视觉中的自回归算法设计提供了新的见解,有望推动这一领域的进一步发展。

项目地址:https://github.com/FoundationVision/VAR

Demo地址:https://var.vision/demo

视频:https://youtu.be/FjjmtGmSodo