苹果本地AI神器让你的Mac更强大!

这是一个为苹果设备上的本地模型提供 OpenAI 兼容 API 的服务器项目,方便开发者在本地运行并调用类似 OpenAI 接口的模型服务。

项目 gety‑ai/apple‑on‑device‑openai(英文名为 Apple On‑Device OpenAI API)是一个挺酷的工具,核心功能是:

📌 项目概览

- 这是一个使用 SwiftUI 构建的 macOS 应用,它在本地启动一个兼容 OpenAI API 的服务器,后端调用的是 Apple 自己的 on‑device Foundation Models(又称 Apple Intelligence)

- 你的应用或脚本只要原本能使用 OpenAI 的

/v1/chat/completions接口,就可以把请求转发到这个本地服务器来实现 AI 聊天功能,数据不会离开你的设备,保证了隐私和低延迟。

为什么它有价值?

隐私保护:所有计算都在本地完成,不向外部服务器发送用户数据。

功能亮点

- 🚀 OpenAI 移植接口:提供像 OpenAI 那样的

/v1/chat/completions(支持 streaming)等端点,还有/v1/models查询可用模型 。 - 🖥️ 使用 SwiftUI 做前端:整出一个图形界面应用,配合 macOS 使用,能规避 Apple 对命令行工具调用模型的 rate limit 限制

- 🔧 可自行编译或直接下载使用:你可以从 Releases 下载预编译 app,也可以 clone 源码用 Xcode 编译跑起来

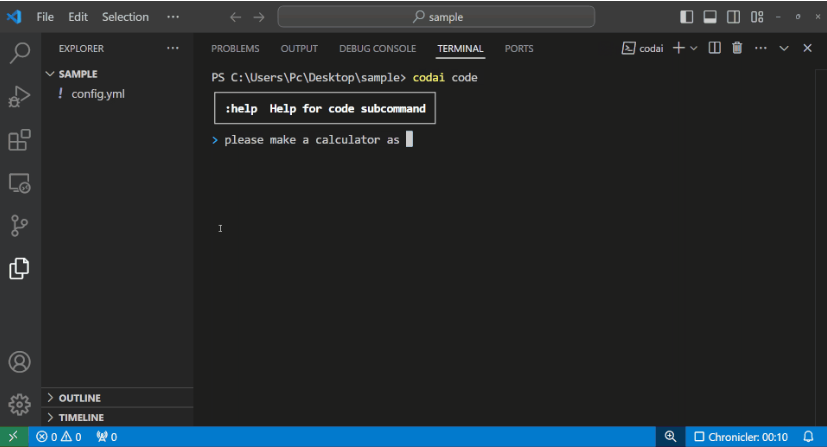

使用流程(简单示意)

- 确保你的 Mac 是运行 macOS 26 beta 且开启了 Apple Intelligence 功能(需在设置里打开)

在社区的讨论

有开发者在论坛上亲身分享:

“I wrapped Apple’s new on‑device models in an OpenAI‑compatible API”

比如提到这工作是 open-source, MIT licensed 的,也强调“客户端用 OpenAI 的调用方式即可,无数据离开本地”。

总结:这个项目做了什么?

这个项目相当于在本地搭建了一个桥梁,它把 Apple 设备上的本地 AI 模型转换为标准的 OpenAI API 接口,让你不用改已有代码,就能利用 Apple 的 on‑device AI 来聊天。特别适合追求隐私、安全、低延迟,并且已经依赖 OpenAI API 的开发者和系统。

Github:https://github.com/gety-ai/apple-on-device-openai

油管:https://youtu.be/yOQYZ8TFw4Y

参考链接

- GitHub: https://github.com/gety-ai/apple-on-device-openai

- Reddit 讨论: https://www.reddit.com/r/LocalLLaMA/comments/1lc6tii/i_wrapped_apples_new_ondevice_models_in_an

- Medium 教程: https://garysvenson09.medium.com/bridge-apple-on-device-llms-to-openai-api

- Blog: https://apidog.com/blog/how-to-convert-apple-on-device-llm-to-openai-compatible-api