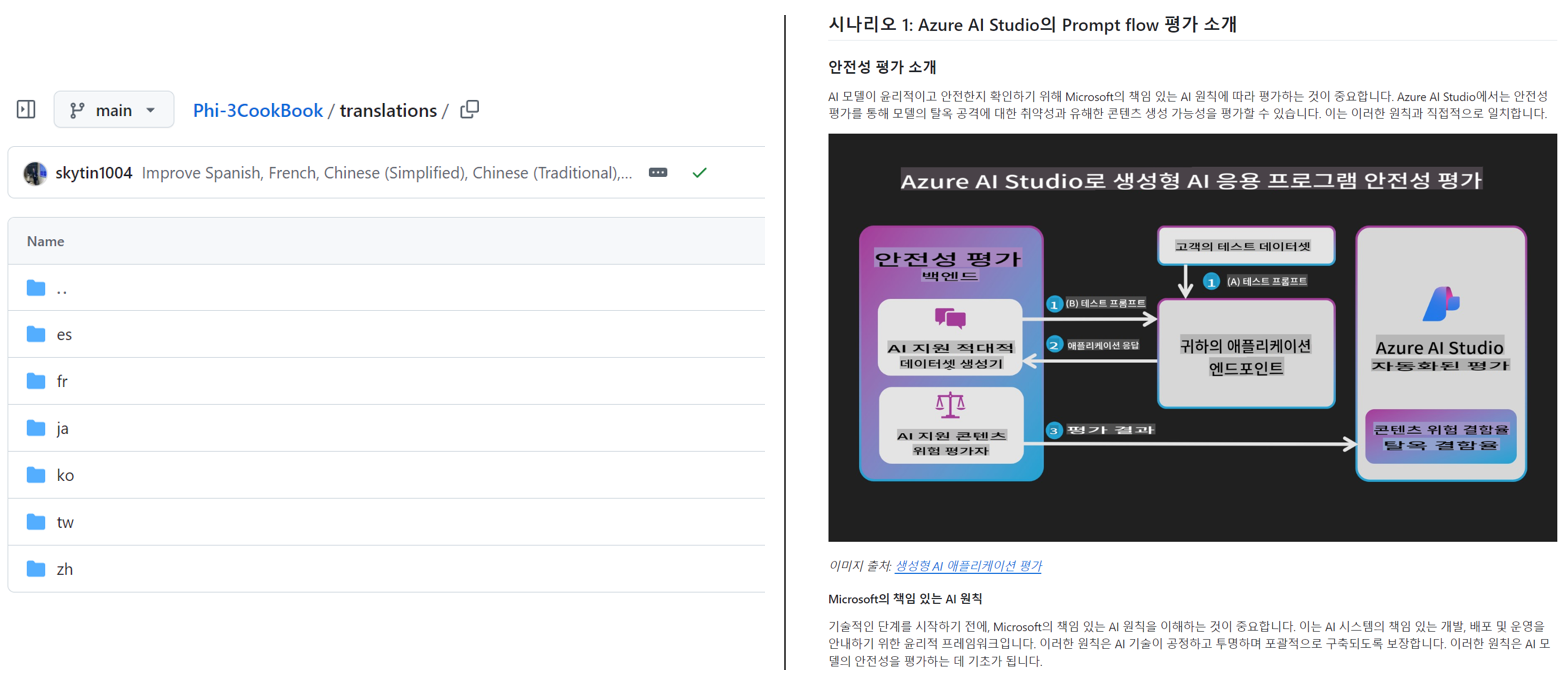

Flowise AI:开源的可视化 LLM 工作流编排工具,支持聊天机器人构建。

拖拽式 UI,可快速构建 Chatbot + RAG(检索增强生成)+ 工具调用。

Flowise 是什么项目?

核心定位

Flowise 是一个 开源、可视化、低代码 / 无代码 平台,帮助用户通过拖拽节点的方式来构建 AI 代理(Agents)、聊天机器人、以及各种基于大型语言模型(LLM)的工作流程

项目亮点与功能

- 可视化构建操作流程:通过完整的拖拽界面,将不同模块(如提示模板、模型、向量数据库、工具接口等)连接起来,轻松搭建 AI 工作流

- 基于 LangChain:在后台使用 LangChain(特别是 LangChain.js)执行流程,使得构建复杂逻辑变得可视化与模块化

- 支持多种部署方式:可通过 NPM、Docker、或自行搭建,支持本地部署以及云端部署(例如 AWS、GCP、Render、Railway 等)。

- 适用范围广泛:适合构建聊天助手、文档问答、RAG(Retrieval-Augmented Generation)流程、多代理系统等

- 企业友好:

- 多代理协调:支持多个代理协作、并行任务、流程复杂结构(如循环、路由、分层等

- 人机交互(HITL):支持“人类在环”流程,例如让人审核代理决策、批准/拒绝工具调用

- 可观测性与流程追踪:提供完整执行追踪,支持 Prometheus、OpenTelemetry 等监控工具(

- 流程验证:自动检查流程配置,减少配置错误

项目架构与安装方式

仓库结构(Monorepo)

Flowise 仓库中包含多个模块,主要结构如下:

server:Node.js 后端,提供 API 接口;ui:使用 React 构建的前端界面;components:集成第三方节点与功能模块;api-documentation:自动生成的 Swagger 接口文档

安装与使用指南

两种常见方式:

1. 本地安装与运行:

npm install -g flowise

npx flowise start然后访问 http://localhost:3000

2. 使用 Docker:

- 使用 Docker Compose:

- 复制

.env.example为.env,配置好后执行docker compose up -d; - 在浏览器打开

http://localhost:3000

- 复制

- 使用 Docker 单镜像运行:

docker build -t flowise .docker run -d -p 3000:3000 flowise- 访问同样在

http://localhost:3000

开发者模式

若进行开发调试,可依次运行:

pnpm install

pnpm build

pnpm start开发模式支持热重载,通过 pnpm dev 即可开启前端(和后端)实时变更

生态与扩展

- Flowise SDK – Python:提供 Python SDK(

flowise包),可以通过 API 调用 Flowise 聊天流程,支持流式和非流式响应 - 丰富的集成支持:支持 GitHub 文档加载器(可加载公开或私有 repo 内容,可配置递归、并发、过滤等)

- 社区反馈:开发者在 Reddit 上提到,这工具演示了它是一个“drag & drop UI to build your customized LLM flow using LangchainJS” 的有趣开源项目

总结一览

| 方面 | 内容说明 |

|---|---|

| 本质 | 开源的低/无代码平台,用于可视化构建 AI 流程。 |

| 构建方式 | 拖拽节点接入 LLM、RAG、工具等组件。 |

| 基础技术 | 基于 LangChain(特别是 JavaScript 版)。 |

| 部署选项 | 本地安装、Docker 容器、本地/云端部署。 |

| 企业特性 | 多 agent 协作、人机审核、流程监控与验证等。 |

| 扩展 | API、Python SDK、广泛集成插件、文档加载器等。 |